規制当局はTeslaのFSDの何を問題視しているのか?

米NTSB(国家運輸安全委員会)とは重大な航空事故、鉄道事故、交通事故などの際に原因究明調査を行うとともに必要となる対策を当局に求める組織であり、日本では運輸安全委員会(JTSB)に相当する組織だ。

NTSBが発出したこの文書は、過去に起きた6件の自動運転並びに運転支援システムに関する重大事故の調査結果が根拠となっている。その6件のうち、4件がTeslaの運転支援システムAutopilotが原因となった事故だ。ちなみに他の2件のうちの1件はUberの自動運転車が歩行者を引いて死亡させた2018年のアリゾナ州での人身事故である。

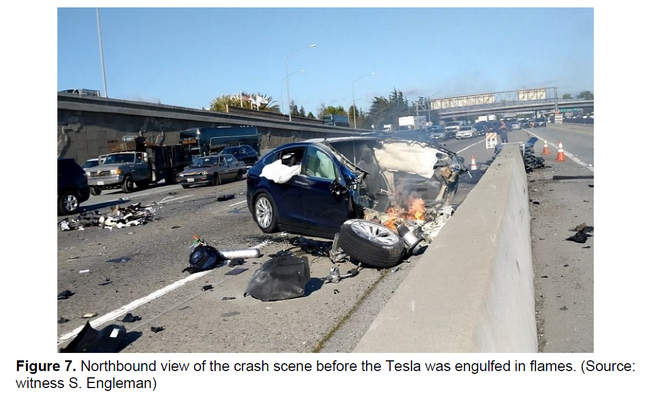

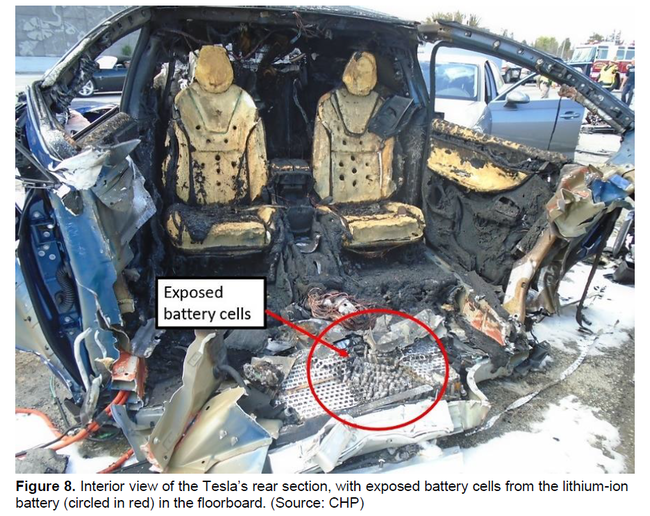

4件のAutopilotに関する事故のうち、3件はTesla車を運転していたドライバーが死亡する結果となっているが、そのうちの1つである2018年3月にカリフォルニア州で起きた事故を簡単に紹介したい。

2018年3月22日に高速道路を走行中のTesla Model Xは車線が切り替わる部分にある三角の進入禁止ゾーンに侵入し、衝突衝撃緩衝具に衝突。反時計回りに回転した車両は前方と後方の2つに割れたのち、他の2台の車両と衝突。Tesla車のバッテリーは破裂し、火災が発生。Tesla車のドライバーは病院に運ばれたが死亡。衝突した他の車両のドライバーのうち1人は軽傷、他の1人は負傷なし。Tesla車はAutopilotによる走行中だった。

なお、事故当時においてドライバーはスマホゲーム中であったことが分かっている。

次の写真はNTSBが公開している事故調査報告書に掲載されているものだが、事故の衝撃の大きさを物語っている。

2月1日のNTSBの文書だが、実はNTSBが規制当局であるNHTSA(運輸省道路交通安全局)にあてたものだ。その狙いはNHTSAに対して自動運転の運転支援システムへの規制を強化させることにある。

過去の重大事故の分析から、運転支援システムの問題についてNTSBは次のように述べている。

過去の重大事故を分析した結果、運転支援システムの起動時にドライバーは注意散漫となっており、運転の監視や走行環境の確認を怠っていた。

また、次のようにも述べている。

一般的に人間は監視者としての役割が苦手であり、自動制御が一定の間に問題なく作動していることが分かるとその状態に満足してしまい、緊急事態に適切に反応できなくなってしまう。

この主張はWaymoのCEOの意見と重なるものだ。

さらに、「NHTSAが安全を担保するための適切な措置を取らなかったために運転設計領域(ODD)を超えて運転支援システムを使うことをTeslaに許してしまった」と、Teslaを名指ししながらNHTSAを批判している。

ちなみに、運転設計領域=Operational Design Domainとは自動運転システムが正常に作動する走行環境を意味する。速度、天候、道路環境、信号の有無、歩行者の存在などのODDを設定し、自動運転システムはODDが成立する条件においてのみ使用すべきという自動運転に関する安全要件の基礎となる概念に基づいている。

NTSBはTeslaのFSDに対しても警告している。

NHTSAが適切な規制を行わないため、運転支援システムが適切に機能しない走行環境(ODD領域外)でもシステムを使用してしまう状況を自動車メーカーに許してしまっている。Teslaは完全自動運転(FSD)が可能であると主張するAutopilotのベータ版を最近リリースしたが、これによって同社は適切な監視や報告の必要がない状態で公道走行試験を行っている。このことは公道を走行する他の車両や歩行者・自転車等に対して安全面での大きなリスクを与えかねない。

TeslaのAutopilotが数々の重大事故を起こしてきた結果から、NTSBはNHTSAに対してTeslaを厳しく規制するように求めていることが分かる。