私たちは生成AI技術を通して、知らず知らずのうちに大規模な搾取に加担してしまっているのでしょうか。また、これからの社会で求められる倫理とはどのようなものなのでしょうか。本コラムでは生成AIが抱える問題点に触れながら、これからの社会に必要な「倫理的創造性」について迫ります。

*本記事は青山学院大学准教授の河島茂生氏の著書『生成AI社会 無秩序な創造性から倫理的創造性へ』(ウェッジ)の一部を抜粋・編集したものです。

連載一覧はこちらから

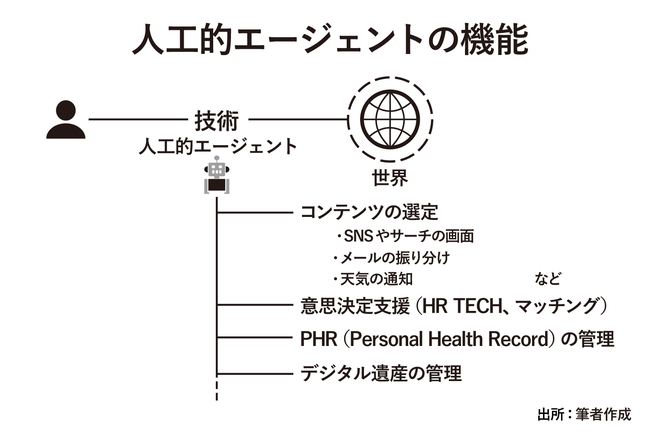

近年、人工的なエージェントが注目を浴びていますので、それについても触れておきましょう。ルチアーノ・フロリディやジェフ・サンダースは、エージェントの条件を、意識や意図、内省を外して以下の三点としました(※1)。

(1) 双方向性:状態変化による刺激に対応すること

(2) 自律性:刺激なしでも状態を変化させる能力

(3) 適応性:状態を変化させる推移規則を変化させる能力

この三条件でエージェントを考えると、さまざまな領域に人が作ったエージェントが入っていることが見えてきます。

たとえば、SNSやサーチエンジンにおけるコンテンツの選定です。デジタルデータの量があまりにも膨大になっており、利用者がすべてをみることは事実上できません。そのため開発・運営側は、利用者にとって心地よいSNSやサーチエンジンになるようにエージェントを作り、それがフィルターのような機能を果たしています。

開発・運営側としては、利用者に継続的にサービスを使ってもらい、広告料やサブスク料を稼がなければなりません。それゆえ人工的なエージェントを使い、これまでの利用行動をもとに利用者が興味をもたず喜ばないコンテンツをあらかじめみえないようにしています。逆に利用者の興味をひくコンテンツを積極的に通知しています。

天気のアプリにも人工的なエージェントは入っています。雨雲が近づいてきたり気温が大幅に変化したりする場合に利用者に通知します。

ヘルステックの領域でも、スマートウォッチで不規則な心拍があったことを通知したり、利用者が事前に医療や介護に関する希望を人工エージェントに入力しておけば、病気が進み意識が朦朧としたとき、それを医療機関がみて治療の判断に役立てたりできるでしょう。

葬式の希望やその人が残したデジタル遺産(亡くなった人のデジタルデータであり、デジタル資産に加え、ソーシャルメディア上のアカウントやコンテンツも含む)の扱いも、エージェントに入力しておけば、それを周りの人が見て決断できます(※2)。

このほか、人工的なエージェントとしては迷惑メール・フィルターや、マルウェア (悪意のあるソフトウェア) からの攻撃を自動的に遮断するセキュリティソフトウェアなどがあります。このように人工的エージェントは、すでに社会のなかに定着しています。今後さらに普及していくでしょう。

念のため述べておきますと、エージェントは、生き物と人工物の両方にまたがった概念であり、人もエージェントでありAI・ロボットもエージェントになりえます。けれども、ともにエージェントであるからといって、両者が同じであるということにはなりません(※3)。

人工エージェントは高度に自動化しており、人がいつも直接的に操作する必要はないといっても、それは生き物ではなく、コンテンツの選定などの目的に応じて外から設計され作られています。

※1Floridi,L. and J.W.Sanders (2004) “On the Morality of Artificial Agents” Minds and Machine, 14(3), 349–379.

※2中川裕志(2020)「AI 倫理指針の動向とパーソナル AI エージェント」『情報通信政策研究』3(2)、I-1-23

※3河島茂生(2021)「情報圏の構築に向けた複数のアプローチ」『情報の哲学のために』勁草書房181-216