国際的に共通しているAI倫理の原則

人類全体の幸福の増進、人間中心、人権尊重、個人の尊厳・自律が挙がっているように、AI倫理の原則で最低限抑えておくべきポイントは、人と機械との違いです。

本書では、生き物と機械との違いとして、オートポイエーシスとアロポイエーシスの区分を持ち出しています。人も生き物ですので、人と機械との違いについて基礎づけを行ったといえるでしょう(*1)。

人を含む生き物と機械との違いが曖昧な面も増えてきていますが、両者の違いを前提としてAI社会を考えることは共通理解になっているといえます。

「人類全体の幸福の増進」 は、倫理学理論でいうと功利主義的な発想にもとづいてるといってよいでしょう。

功利主義的な考えかたは、一言でいえば、「最大多数の最大幸福」 という言葉に表されています。それまでの慣習や常識ではなく、より多くの人がより多くの幸福を得ることを正しいとします。逆に苦痛を増やすものは不正であり、改善すべきものです。

功利主義はあくまで結果をみます。したがって、仮に出世や金儲け、有名になりたいといった目的・動機であっても、あるいは一部の人に苦痛をもたらすことになっても、結果として全体の幸福が増えればよいのです。つまり結果オーライであればよいのです。

そのため、直観的には不正だと思うことを肯定してしまったり、少数の人の幸福を軽んじたりする傾向があります。

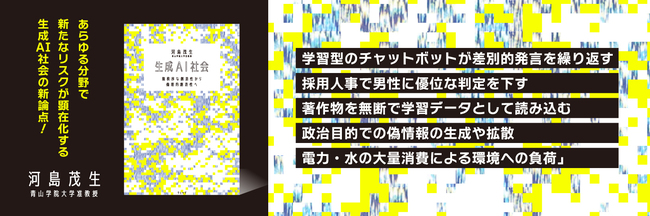

なお書籍『生成AI社会』で書いていますように、技術倫理は研究・開発の初期段階から社会に対してよい・正しい影響を与える技術を考えていきますので、前もって結果を見込んでいます。

そのため、最大多数の最大幸福になるように功利主義「的」に発想して技術を考えることにならざるをえません。実際に結果がどうなるかとはズレが出てしまうこともあるでしょう。

一方で「人間中心、人権尊重、個人の尊厳・自律」は、倫理学理論の義務論に沿った考えかたといえます。

義務論は、功利主義とは違って結果は無視し、したがうべき義務にもとづいた動機であることを正しいとします。したがうべき義務として代表的なのは、普遍化できることであり、人を単なる手段・道具として扱わないことです。

義務論において人は、単なるモノではなく理性があり尊厳があります。権利でいうと、ほかのモノとは違って人には人権があります。AIと比較すれば、AIはモノであるため、単なるモノではない人を中心に考えていくべきでしょう。

*1 詳しくは『生成AI社会 無秩序な創造性から倫理的創造性へ』(ウェッジ)の第2章参照」