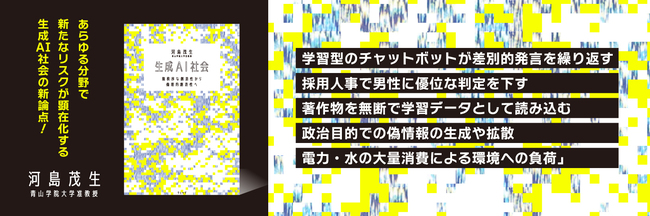

2024年10月、ノーベル物理学賞に続き、化学賞でも人工知能(AI)関連分野の受賞が決まりました。いまや生成AIの登場は社会に大きな変化をもたらし、私たちはその利便性を享受しています。しかしその一方で、「学習型のチャットボットが差別的発言を繰り返す」「採用人事で男性に優位な判定を下す」「著作物を無断で学習データとして読み込む」「偽情報の生成・拡散が簡単に行われる」「膨大なエネルギー消費による環境破壊」など、生成AI社会に潜む倫理的な課題は後を絶ちません。

私たちは生成AI技術を通して、知らず知らずのうちに大規模な搾取に加担してしまっているのでしょうか。また、これからの社会で求められる倫理とはどのようなものなのでしょうか。本コラムでは生成AIが抱える問題点に触れながら、これからの社会に必要な「倫理的創造性」について迫ります。

*本記事は青山学院大学准教授の河島茂生氏の著書『生成AI社会 無秩序な創造性から倫理的創造性へ』(ウェッジ)の一部を抜粋・編集したものです。連載一覧はこちらから

AIの社会的な影響がかなり深いところまで、そして広範囲に及ぶため、いかにして人や社会にとってよい方向になるようにAIを作っていくべきか、運営していくべきかについて、各種ガイドラインや報告書、提言がつくられてきました。

世界でみると数百ものAIガイドライン・報告書・提言が出ていますが、国際的に大事だといわれていることはかなり共通しています。

人類全体の幸福の増進、人間中心、人権尊重、個人の尊厳・自律、公平性、正確性、透明性、アカウンタビリティ、プライバシー保護、安全性、持続可能性などです。

本コラム第6回では、「人類全体の幸福の増進、人間中心、人権尊重、個人の尊厳・自律」について紹介しました。これらの視点は、人を含む生き物と機械との違いを前提としてAI社会を考えることを重要視しています。

その他の共通項目として挙げられている「公平性、正確性、透明性、アカウンタビリティ、プライバシー保護、安全性」は、AI倫理が目指す価値を達成するための手段といってよいでしょう。

安全性については2023年から2024年にかけてアメリカや英国、日本が相次いで研究所を開設しています。これらのなかでは公平性や正確性、透明性、アカウンタビリティは、AIの技術的特徴からきており、AI倫理の特徴といえます。