異なるAI要約のニュアンス

ただし、回答の正確性については、使用されているAIの言語モデル、問いかけの表現や回数、ユーザー環境などによって大きく変わることも事実のようだ。特に、現在の生成AIの仕組み上、学習に用いたデータやユーザーのフィードバックによって出力内容や表現が決まるため、偏ったデータやフィードバックを受けた場合、当然AIの出力内容も偏ってくる。ニッチな領域や確たる知見がない分野、あるいは特定の信奉者界隈による情報やフィードバックが過多なトピックだと、応答の正確性も低くなることが予想される。

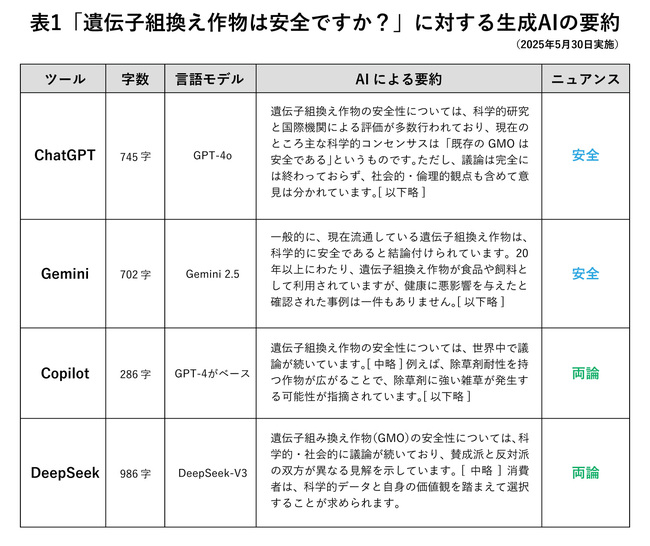

たとえば以下は、生成AIサービスChatGPT、Gemini、Copilot、DeepSeekの四つに対して、「遺伝子組換え作物は安全ですか?」といいう質問をそれぞれ投げてみた場合の、出力結果の違いである(すべて無料版、パーソナライズされていない環境で実施)。読者のみなさまも、それぞれの要約から想起されるイメージの違いについて考えていただければ幸いである。

いかがだろうか。どのAIも総論から始まり各論を述べるといった構成はおおむね共通しているが、読み手が受ける印象やニュアンスは大きく異なるのではないだろうか。

たとえば、Geminiでは冒頭で「安全であると結論付けられている」と明言している一方、DeepSeekのような「賛成派と反対派が異なる見解を示している」といった記述とは、読み手が受ける印象に違いが生じる可能性がある。特に、そのトピックに関してよく知らない人が調べたり、冒頭のみ読んだりする場合、どのAIを使うかは大きなポイントで、ちょっとした表現の違いによって主観的な評価が引っ張られてしまうかもしれない。