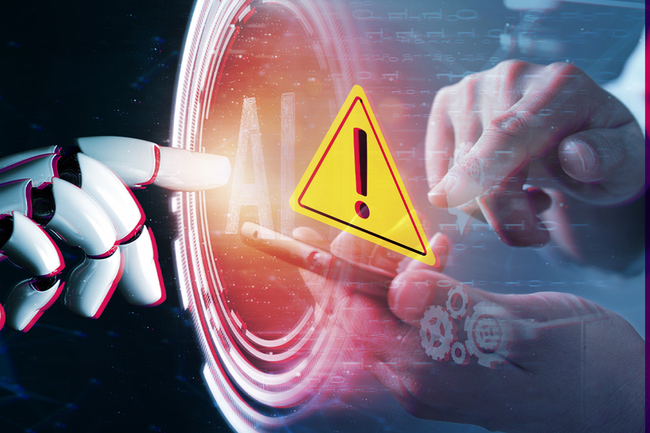

2024年10月、ノーベル物理学賞に続き、化学賞でも人工知能(AI)関連分野の受賞が決まりました。いまや生成AIの登場は社会に大きな変化をもたらし、私たちはその利便性を享受しています。しかしその一方で、「学習型のチャットボットが差別的発言を繰り返す」「採用人事で男性に優位な判定を下す」「著作物を無断で学習データとして読み込む」「偽情報の生成・拡散が簡単に行われる」「膨大なエネルギー消費による環境破壊」など、生成AI社会に潜む倫理的な課題は後を絶ちません。

私たちは生成AI技術を通して、知らず知らずのうちに大規模な搾取に加担してしまっているのでしょうか。また、これからの社会で求められる倫理とはどのようなものなのでしょうか。本コラムでは生成AIが抱える問題点に触れながら、これからの社会に必要な「倫理的創造性」について迫ります。

*本記事は青山学院大学准教授の河島茂生氏の著書『生成AI社会 無秩序な創造性から倫理的創造性へ』(ウェッジ)の一部を抜粋・編集したものです。連載一覧はこちらから

生成AIは、さまざまな倫理的問題を引き起こしてきました。

ChatGPTを開発・運営しているOpenAIは、リスクやセキュリティ、安全性、経済、法、教育、健康、核リスク、公平性、誤情報・偽情報の専門家50人以上の協力を得て、有害なコンテンツの生成やハルシネーション (幻覚、つまりデタラメを出力すること) などについて議論して、リスクを抑えようとしています(*1)。

OpenAIにかぎらず、最近のテクニカル・レポートは、内容のほとんどがAIガバナンスの話になっており、生成AIの社会的影響の大きさやガバナンスの難しさがうかがえます。

ここでは、生成AIがもたらす倫理的課題として「偽情報」について取り上げていきます。

生成AIを使えば、ハルシネーションにもとづく誤情報(misinformation)だけでなく、人が意図的に虚偽を入れて、容易に偽情報(disinformation)を作ることができます。悪意をもって事実を捏造・歪曲しやすくなっており、簡単に悪用することができます。

生成AIが一気に使われだす前から、偽情報はインターネット上で蔓延していました。災害のときでも新型コロナウイルスの危機のときでも、偽情報は広がりました。

2016年4月の熊本地震のとき、「動物園からライオン放たれたんだが 熊本」というデマが流れ、現場は混乱しました。新型コロナウイルスのときにも、自分たちの栄養補助食品や健康法の書籍を売ったりセミナーでお金を稼ぐために、ワクチンの効果を否定した人たちがいました。

誰もが簡単にインターネットに偽情報を投稿でき、反響があるとそれは一気に多くの人に知れ渡り、記録としても残るようになりました。また、デマを信じる人たちが集まり結託して行動ができるようにもなりました。

そうしたことが生成AIによって加速しています。テキストや画像、音声、動画を問わず、偽情報の作成があまりにも手軽になりました。

日本で生成AIを使った偽情報としてよく知られているのは、2022年の静岡県の水害の偽画像でしょう。画像生成AIのStable Diffusionを使って多くの建物が濁流に飲み込まれている画像が作られました。

Twitter(現・X)に投稿され、多くの人の目に触れました。この偽情報は、本人が「大した目的はない」といっていることから、軽いいたずらから行われたといえます。このほか、岸田文雄元首相の偽動画も話題になりました。

*1 OpenAI (2023) “GPT-4 Technical Report”(accessed 2024-05-31)